Note: ezt a bejegyzést az Evolution konferenciás előadásomhoz kapcsolódóan írtam. De azért bárkinek hasznos lehet… :-)

A legfrissebb statisztikák szerint az online szolgáltatók 91%-a tudja, hogy mi az az A/B tesztelés, de csak 11% az, aki ténylegesen (legalább egyszer) futtatott A/B tesztet az oldalán. Pedig az A/B tesztelésnek forintban mérhető, azonnali haszna van. Egy külföldi esettanulmány:

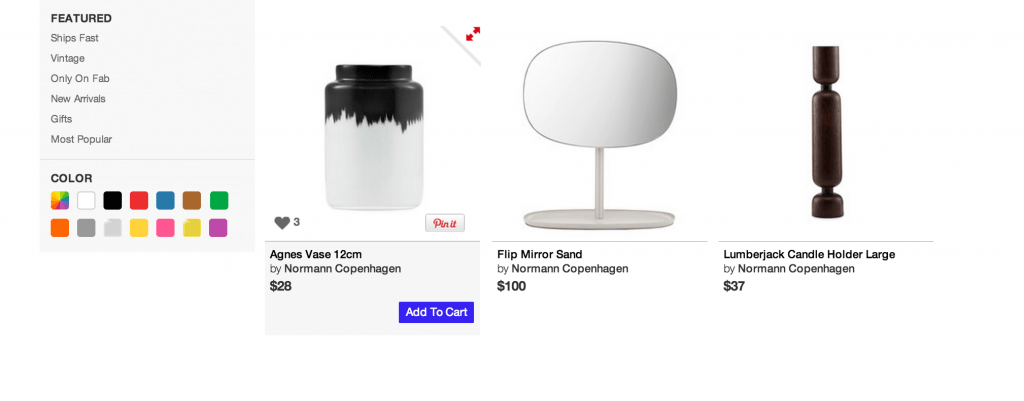

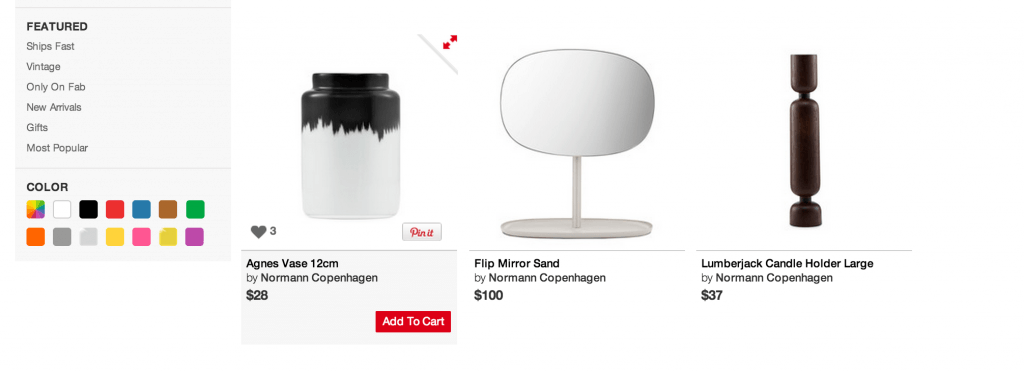

A fab.com e-commerce startup egyetlen dolgot tesztelt az oldalán. A lenti két képen látszik is: az „Add to cart” gomb színét.

Az oldalra érkező látogatók fele-fele arányban véletlenszerűen kapták meg vagy a piros vagy a kék verziót. Ekkora látogatószámnál viszonylag kevés tesztből kiderült a válasz a kérdésre: melyik gombszín hoz több kattintást, ezáltal magasabb konverziót és több profitot. Az eredmény pedig megdöbbentő: 49%, ami éves szinten dollár-milliókat(!) jelent a fab.com-nak. A kísérlet beállítása és elindítása nettó 2 óra munkát jelentett nekik. Azt hiszem, ezek után nehéz lenne azt mondani, hogy az A/B tesztelés nem hasznos.

De hogyan is kell A/B tesztelni? Íme 4 szabály, amit én a legtöbbször látok elrontani olyan ügyfeleknél, akik maguknak kezdték el csinálni az A/B tesztjeiket. (Ezt nem amolyan „cikizés”, csak azért írom le, hogy más ne essen ezekbe a gyakori hibákba! :-))

1. Egy időben fusson a két verzió!

Tehát az nem A/B teszt, hogy februárban kiteszem az egyik verziót, márciusban pedig a másikat és mérem, hogy melyik hoz több kattintást… Miért nem? Azért, mert ebben az esetben közbeszólhat a szezonalitás. Azaz lehet, hogy márciusban nagyobb igény van az adott termékre (pl. tavaszi cipő), mint februárban volt és ez is befolyásolja a konverziót. Egy korrekt A/B tesztben a különböző verziók egymással párhuzamosan, egy időben futnak.

2. A teszt csoport és a kontroll csoport azonos összetételű legyen!

Pl. ha a fizetős felhasználóim perszonalizált hírlevelet kapnak, az ingyenes felhasználóim pedig nem, akkor a hírlevélből jövő átkattintási arányok nem csak azért lesznek eltérőek, mert más a levél tartalma, hanem azért is, mert más a felhasználói csoportok elkötelezettségi szintje. Ha a fizetős felhasználók teljesen ugyanazt a levelet kapnák, mint az ingyenesek, könnyen lehet, hogy mivel ők elkötelezettebbek a termék iránt, amúgy is többen kattintanának. Éppen ezért, ha tényleg a levél tartalmát akarod tesztelni, akkor vagy a fizetős felhasználókat kell véletlenszerűen két csoportba osztanod, vagy az ingyeneseket. A lényeg, hogy a kontroll csoport és a teszt csoport azonos típusú embereket tartalmazzon.

3. Legyen célja a tesztnek!

És ez nem csak arról szól, hogy ne dolgozzunk feleslegesen, hanem arról is, hogy ténylegesen: egy A/B tesztet csak akkor lehet kiértékelni, ha az ember már a tervezés fázisban eldönti, hogy mi lesz az az 1, maximum 2 mérőszám, aminek a változását figyeli és ami alapján azt mondja, hogy az egyik verzió sikeresebb, mint a másik (mint pl. a fab.com esetében a gombra kattintás).

4. Csak egy dolgot változtass!

Ezt nehéz betartani és általában nem is szokták. De vedd figyelembe, hogy minél több elemet változtatsz a két verzió között, annál nehezebb lesz eldönteni, hogy pontosan melyik volt a kulcselem, ami az egyik verziót sikeresebbé tette, mint a másikat (pl. a fab.com csak a kék és a piros gomb közötti különbséget mérte.

És hogy hogyan is kell beállítani egy A/B tesztet? Természetesen ebben mi is tudunk segíteni, de ha egyedül szeretnél belevágni, ezen 3 platform valamelyikét tudom ajánlani:

Visual Website Optimizer

Optimize.ly

Google Analytics Experiments

FOLYTATÁS: Szignifikáns vagy sem? Így mérd az AB-teszted eredményességét!

Mester Tomi